Sitemap vs Robot.txt vs Llms.txt: Was ist wichtiger

Die Verwirrung rund um robots.txt, Sitemaps und das neu eingeführte llms.txt hat zu einem falschen Gefühl der Gleichwertigkeit zwischen Tools geführt, die tatsächlich sehr unterschiedlichen Zwecken dienen. Die wirkliche Erkenntnis ist, dass nur robots.txt und Sitemaps beeinflussen, wie Suchmaschinen Inhalte crawlen und indexieren, wohingegen llms.txt keine messbare Wirkung hat und von Google überhaupt nicht gelesen wird. Die Behandlung von llms.txt als Kontrollebene führt zu falschen Erwartungen und übersehenen technischen Grundlagen. Der praktische Wandel besteht darin, sich wieder auf bewährte Crawl-Richtlinien und eine Clean-Discovery-Architektur zu konzentrieren, um Inhalte zu schützen und die Sichtbarkeit zu erhöhen, anstatt sich auf experimentelle Dateien zu verlassen, die nicht unterstützt werden.

Es herrscht immer mehr Verwirrung robots.txt gegen llms.txt und wie diese Dateien mit deiner Sitemap interagieren. Jede erfüllt einen einzigartigen Zweck im SEO-Ökosystem, aber nicht alle sind gleich wertvoll. Während robots.txt und Sitemaps nach wie vor von grundlegender Bedeutung für die Sichtbarkeit in den Suchergebnissen und die Effizienz beim Crawlen sind, hat sich llms.txt trotz der jüngsten Aufmerksamkeit als eher als Hype als als Hilfe erwiesen.

Wenn Sie wissen, was die einzelnen Dateien tun und wie sie zueinander in Beziehung stehen, kann dies über Erfolg oder Misserfolg Ihrer SEO-Leistung entscheiden. Lassen Sie uns das aufschlüsseln.

Der Zweck von robots.txt und warum es immer noch wichtig ist

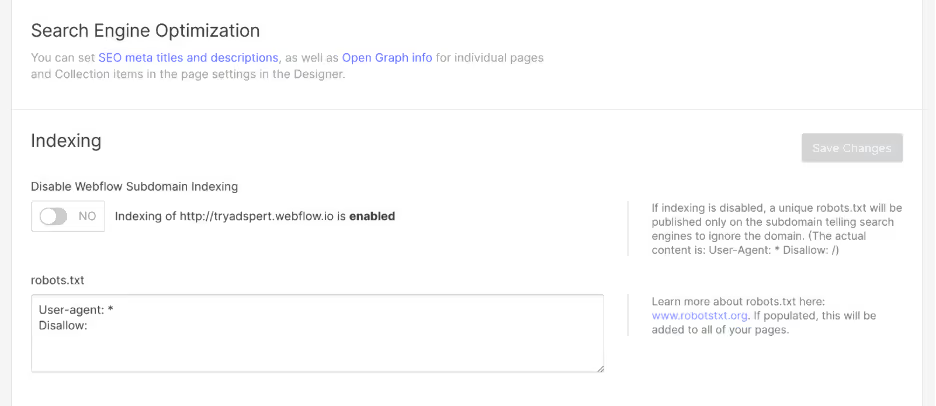

Das robots.txt file ist eines der ältesten und wichtigsten Tools in der technischen Suchmaschinenoptimierung. Es teilt den Suchmaschinen-Crawlern mit, welche Bereiche Ihrer Website indexiert werden sollen und welche privat bleiben sollen. Eine gut konfigurierte Datei robots.txt hilft dir dabei, das Crawl-Budget zu kontrollieren, doppelte Inhalte zu vermeiden und sicherzustellen, dass sensible Verzeichnisse oder Skripte nicht indexiert werden.

Zu den bewährten Methoden für robots.txt gehören:

- Erlaube wichtige Inhalte und blockiere unnötige Dateien wie Admin-Seiten, interne Suchergebnisse oder temporäre Inhalte.

- Fügen Sie einen Link zu Ihrer Sitemap hinzu, damit Suchmaschinen alle indexierbaren Seiten schnell finden können.

- Testen Sie Ihre Datei mit dem robots.txt Tester der Google Search Console, um ein versehentliches Blockieren zu verhindern.

- Aktualisiere die Datei regelmäßig, wenn sich deine Seitenstruktur weiterentwickelt.

Für Webflow-Benutzer ist die Optimierung von robots.txt einfach, da Sie sie direkt auf der Plattform verwalten können. Wenn Sie von robots.txt aus auf Ihre Sitemap verlinken, können sowohl Google als auch Bing Ihre Seitenhierarchie schneller verstehen.

Weitere Informationen zur Optimierung der Struktur Ihrer Webflow-Site finden Sie in unserem Dienstleistungen der Webflow SEO-Agentur.

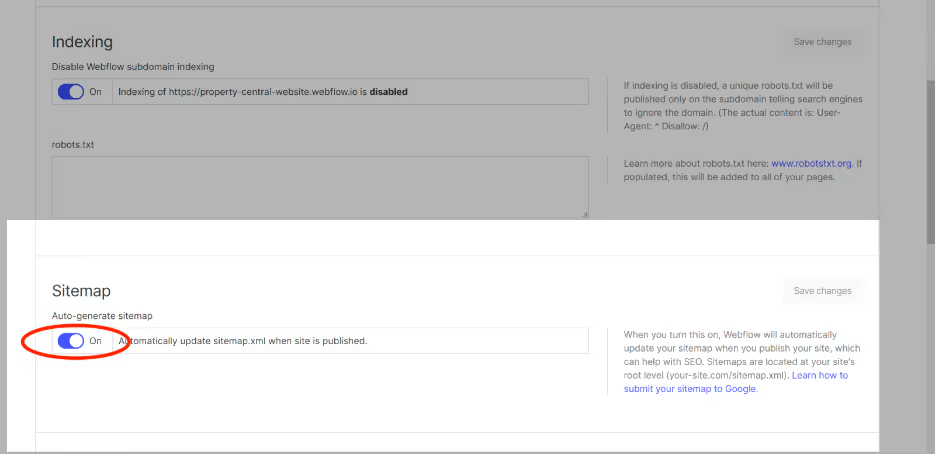

Sitemaps und ihre Vorteile verstehen

Eine Sitemap ist eine strukturierte Datei, die alle URLs auf Ihrer Website auflistet und Suchmaschinen hilft, Ihre Seiten effizient zu finden und zu crawlen. Es gibt zwei Haupttypen von Sitemaps:

XML-Sitemaps - In erster Linie für Suchmaschinen, die Metadaten wie Aktualisierungshäufigkeit und Priorität bereitstellen. Diese sind entscheidend für große Websites mit vielen Seiten oder komplexer Navigation.

HTML-Sitemaps - Konzipiert für Benutzer und bietet einen für Menschen lesbaren Überblick über die Struktur Ihrer Website. Sie sind zwar nicht verpflichtend, können aber das Nutzererlebnis und die interne Verlinkung verbessern.

Beide Typen arbeiten Hand in Hand mit Ihrer Datei robots.txt. Bei richtiger Implementierung stellen sie sicher, dass kein wertvoller Inhalt unentdeckt bleibt. In Webflow kann die Generierung und Pflege von XML-Sitemaps automatisiert werden, während die Erstellung einer HTML-Sitemap die Navigation und Barrierefreiheit verbessern kann.

Wo llms.txt ins Bild passt

Im Zuge der Weiterentwicklung der Diskussionen über die Nutzung von KI-Inhalten entstand llms.txt als Vorschlag für Verlage, auszudrücken, wie ihr Material in großen Sprachmodellen behandelt werden sollte. Konzeptionell sollte es sich wie eine Einstellungsdatei verhalten, die die Art und Weise widerspiegelt, wie Sitemaps und robots.txt mit Suchmaschinen kommunizieren. Seine praktischen Auswirkungen sind jedoch nach wie vor nicht vorhanden. Es gibt keine technischen Standards, die regeln, wie KI-Crawler es interpretieren sollten, und große Plattformen haben es nicht übernommen. Google hat öffentlich erklärt, dass es llms.txt überhaupt nicht liest oder sich darauf verlässt, sodass die Datei keinen Einfluss auf die Zugriffskontrolle, die Nutzung von Inhalten oder die Zuordnung hat.

Robots.txt vs llms.txt: Die neue Debatte

Das robots.txt gegen llms.txt Eine Debatte entstand, als die vorgeschlagene Datei llms.txt in die Konversation eintrat. llms.txt wurde als potenzieller Standard für die Steuerung des Zugriffs großer Sprachmodelle (LLMs) auf Webseiteninhalte eingeführt und sollte Webmastern eine Methode bieten, mit der sie Berechtigungen für KI-Crawler festlegen können.

Laut Googles eigener Dokumentation und Aussagen (um eine Quelle hinzuzufügen), hat die Datei llms.txt wenig bis gar keine praktischen Auswirkungen. Google hat klargestellt, dass die Anweisungen von llms.txt derzeit nicht gelesen oder befolgt werden, was sie eher symbolisch als funktional macht. Sogar Berichte von Suchmaschinenland bestätige, dass es sich nicht um einen offiziellen oder anerkannten Webstandard handelt.

Warum llms.txt noch nicht nützlich ist

Die Idee hinter llms.txt, Webmastern die Kontrolle darüber zu geben, wie KI-Modelle ihre Inhalte verwenden, ist zwar interessant, aber es mangelt ihr an Durchsetzung und Akzeptanz. Es gibt keine formalen Richtlinien oder technischen Rahmenbedingungen, an die sich KI-Crawler halten könnten. Darüber hinaus stützen sich die meisten KI-Systeme bereits auf bestehende Webcrawler, die die Regeln von robots.txt respektieren.

Das Fehlen einer Zuordnung ist ein weiterer Nachteil. Selbst wenn llms.txt das Scraping von Daten einschränken würde, würde dies das Problem nicht lösen, dass KI-generierte Inhalte den ursprünglichen Erstellern nicht angemessen genannt werden. Dadurch sind Verlage mit dem ständigen Problem der Wiederverwendung von Inhalten konfrontiert, ohne Anerkennung oder Wertaustausch.

Welche Datei ist am wichtigsten?

In Bezug auf die Auswirkungen auf die Suchmaschinenoptimierung sind robots.txt und XML-Sitemaps llms.txt nach wie vor weit überlegen. Sie beeinflussen direkt, wie Suchmaschinen Ihre Website entdecken, crawlen und bewerten.

Hier ist eine einfache Hierarchie, an die Sie sich erinnern sollten:

- Robots.txt steuert den Crawler-Zugriff.

- Sitemap.xml hilft Suchmaschinen, Inhalte effizient zu finden.

- Llms.txt bietet derzeit keinen messbaren SEO-Vorteil. Google hat ausdrücklich erklärt dass das Konzept von llms.txt keinen Wert für Crawling, Indexierung oder KI-Trainingskontrolle bietet und keinen Einfluss auf das Suchranking oder die Aufnahme von Datensätzen hat. Daher bietet die Datei keine praktische Kontrolle, keinen Vorteil bei der Zuordnung und auch keinen technischen Vorteil im Vergleich zu etablierten Standards wie robots.txt.

Wenn Sie also möchten, dass Ihre Website bei der organischen Suche gut abschneidet, sollten Sie der Pflege einer sauberen Datei robots.txt und einer aktuellen Sitemap Priorität einräumen.

Abschließende Gedanken

Wenn Sie Sitemap mit robots.txt und llms.txt vergleichen, ist das Fazit klar: Konzentrieren Sie sich auf das Wesentliche, das die Suchmaschinenoptimierung bewegt. Llms.txt mag in Zukunft nützlich werden, wenn sich die Webstandards weiterentwickeln, aber im Moment spielt es keine praktische Rolle, um Ihre Sichtbarkeit zu erhöhen oder Ihre Inhalte zu schützen.

Eine richtig konfigurierte Datei robots.txt und genaue Sitemaps liefern immer einen messbaren Wert. Sie sorgen dafür, dass Ihre Website effizient gecrawlt wird, stellen die Auffindbarkeit sicher und bieten eine Struktur, auf die sich Suchmaschinen verlassen.

Kurz gesagt, wenn es darum geht robots.txt gegen llms.txt, die kluge Wahl ist, Ihre Energie dort zu investieren, wo es darauf ankommt, in Tools, die Suchmaschinen tatsächlich verwenden.

.svg)

.svg)